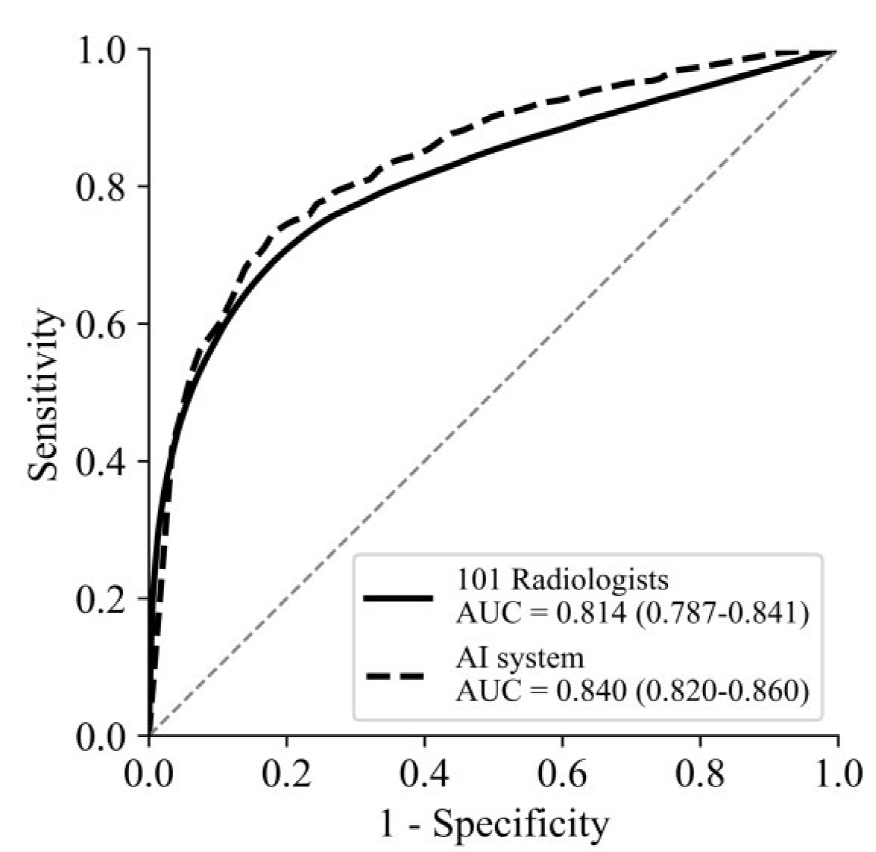

La semana pasada estuve en una conferencia internacional de informática médica en Valencia, dónde se reunieron informáticos, radiólogos, físicos médicos, ingenieros clínicos, etc. Allí se habló, entre otras muchas cosas, del papel de la inteligencia artificial (IA) en el diagnóstico por imagen de enfermedades. Este sigue siendo un tema candente en la medicina ya que grandes estudios han demostrado niveles de detección iguales o superiores al radiólogo medio. En la siguiente figura, se observa una curva dónde se ve que el rendimiento de un sistema de IA para la detección de cáncer de mama (línea discontinua negra) es superior a la media de 101 radiólogos (línea continua), aunque existen radiólogos que son superiores a la IA. Este trabajo corresponde a un estudio exhaustivo muy bien diseñado donde se han examinado más de 2500 pruebas de mamografía realizadas en 7 países.

El problema que encontramos muchas veces, es que los resultados asombrosos que nos muestran de la IA solo funcionan para un reducido número de imágenes y unas condiciones determinadas. Los profesionales recomiendan que antes de adquirir algoritmos de IA (como cualquier otro), éstos se validen con un gran número de imágenes de diferentes centros y fabricantes para verificar su robustez. Y en este sentido, hace unos años que la comunidad científica organiza competiciones (o “challenges” en inglés) donde los investigadores envían sus algoritmos para ser testados en un conjunto de imágenes desconocidas para el sistema. De esta forma, diferentes sistemas de IA se comparan para una misma base de datos. A partir de aquí, se publica un ranking de los grupos que han tenido mejor puntuación para realizar una determinada tarea.

Por otro lado, se habla mucho actualmente de la interpretabilidad de los sistemas de IA. Esto quiere decir, que no solo el sistema debería proporcionar un diagnóstico (cáncer o no cáncer, por ejemplo), sino que, además muestra las características de la imagen que utiliza para llegar a esa conclusión. De esta forma, se puede verificar su funcionamiento o incluso aprender de el. En este sentido, se detectó un sistema que aprendia, entre otras cosas, las etiquetas que ponían los técnicos a la hora de realizar una placa de rayos x. De tal forma que el sistema aprendió a detectar pacientes enfermos en aquellas máquinas portátiles que se utilizan en pacientes enfermos de baja movilidad (https://medium.com/@jrzech/what-are-radiological-deep-learning-models-actually-learning-f97a546c5b98 )

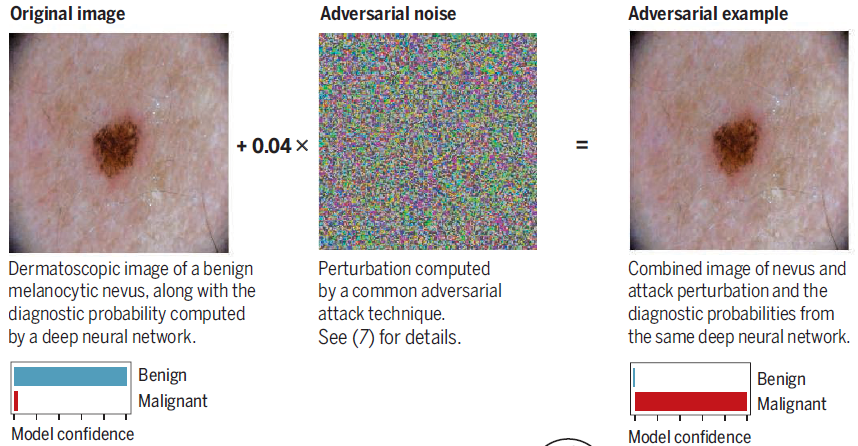

Ya lo comentamos en una carbonoticia anterior (https://cienciacarbonica.es/ordenadores-que-dan-guacamole-por-gato/), a veces pequeñas variaciones imperceptibles para el ser humano, pueden cambiar drásticamente la respuesta de un sistema de IA y llevar a conclusiones erróneas que nunca cometería un humano. Se ha visto, por ejemplo, como unas pegatinas en una señal de stop puede ser interpretada con una señal de limitación de velocidad a 45 mph.

O un diagnóstico de cáncer de piel benigno convertirse en maligno al añadir ruido imperceptible en la imagen.

Lo que es cierto es que la IA representa una gran herramienta con mucho potencial para dar soporte en muchos campos como la medicina. Sin embargo, se requiere de una mayor madurez tecnológica y conocimiento de su funcionamiento para convencernos de sus resultados, y solo la ciencia rigurosa nos dará las respuestas.

Un comentario