Con la llegada de los nuevos programas basados en inteligencia artificial (IA) se plantean muchos escenarios donde las máquinas tomen decisiones por si solas. Esto lo podemos ver, por ejemplo, en la conducción autónoma de vehículos o en el diagnóstico de enfermedades. Como cabría pensar, estos nuevos escenarios tienen una gran componente ética que actualmente se está siendo debatida por la comunidad científica internacional. ¿Cómo afecta eso al desarrollo e implementación de la IA?

Como hemos visto a través de diferentes #carbonoticias, la IA tiene muchísimas ventajas en la práctica clínica. Por ejemplo, la IA ha demostrado que puede mejorar el diagnóstico de algunas enfermedades, aunque también tiene potencial para disminuir costes en la sanidad pública, cubrir la falta de profesionales en muchas especialidades/países e incluso se habla de mejorar las habilidades de los médicos. Es por este motivo que los últimos avances de la IA se han convertido en una herramienta potente para el dar soporte al diagnóstico clínico.

Sin embargo, la IA también ha despertado muchas dudas entre los profesionales. Por un lado, se hablado de la posibilidad de que la IA “sustituya” al médico. Pero también se comenta mucho los fallos (a veces impensables) que puede cometer la IA, como comentamos aquí hace unas semanas (https://cienciacarbonica.es/es-la-inteligencia-artificial-es-tan-buena-como-se-dice/). Toda esta (des)información, a veces motivada de manera deliberada, puede incluso llegar a repercutir en la confianza de los pacientes en la tecnología médica.

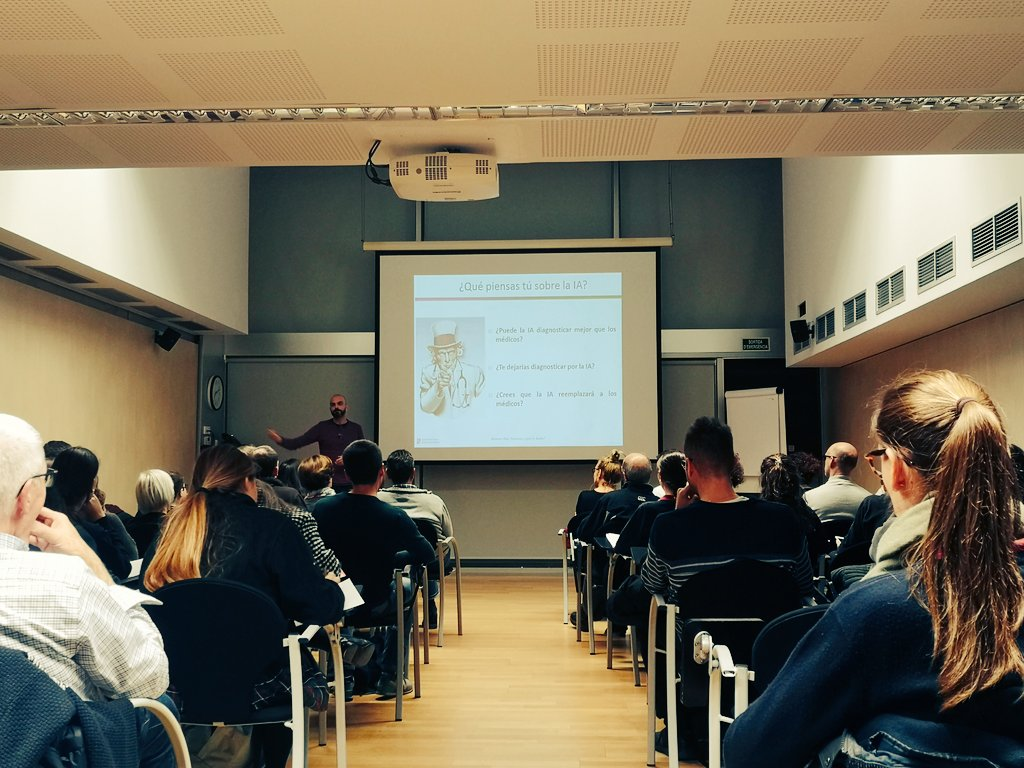

En este sentido, y coincidiendo con la semana de la ciencia, la semana pasada hice una charla para dar a conocer a la gente los avances de la IA y explicar muy brevemente como funciona ésta. De esta manera, se pretende que la sociedad tome decisiones a partir de información científica de primera mano.

Claramente, el desarrollo de los programas de IA requiere de ciertos conocimientos técnicos y representa una tarea compleja. Como se ha comentado en muchas ocasiones, para “enseñar” a una máquina a realizar una tarea, se requiere de muchos datos (p.ej. imágenes clínicas de pacientes). A pesar de vivir en la era de los grandes volúmenes de datos (Big Data) donde en los últimos 2-3 años hemos generado el 90% de los datos de la historia de la humanidad, existen problemas, sobre todo éticos, para hacer uso de esta gran cantidad de información.

Hay que tener en cuenta que, siguiendo con las normativas nacionales e internacionales, se ha de preservar el anonimato de los pacientes al utilizar estos datos. También se ha de evitar los sesgos. Esto es importante ya que muchas veces los propios datos han sido manualmente tratados por humanos y, sin darnos cuenta, podemos “enseñar” a una máquina algún tipo de comportamiento no deseado. Otro aspecto a tener en cuenta es como se aplican estos programas a la práctica clínica, como se monitorizan y como se toma la decisión final en el diagnóstico. Muchas preguntas que poco a poco van teniendo respuestas por parte de los diferentes actores implicados en la salud (empresas, científicos, médicos, pacientes).

Por este motivo, y como hemos explicado anteriormente, actualmente se habla mucho de la IA explicable, donde las máquinas aportan más información al médico/usuario final de como se ha tomado una decisión. Esto facilitará mucho entender mejor a las máquinas y dar respuestas a todos los problemas éticos que se nos presenten.

¡Que la IA te acompañe!