Siguiendo en mi línea de Carbonoticias sobre Inteligencia Artificial (IA), hoy me gustaría contar un poco sobre los datos, esos grandes desconocidos que juegan un papel importantísimo en el aprendizaje de la IA, y que se consideran actualmente el petróleo del siglo XXI.

Existen varias técnicas para enseñar a una IA a realizar una tarea (p. ej detectar vacas en una foto). Las dos más comunes son: el aprendizaje supervisado donde la IA aprende mediante ejemplos etiquetados (p. ej. imagen de una vaca etiquetada como vaca) y el aprendizaje no supervisado, en el que la IA aprende mediante la búsqueda de patrones comunes entre el conjunto datos que posteriormente agrupa (p. ej. imagen de una vaca sin saber que es una vaca, pero la IA aprende que tienen 2 ojos, 4 patas, un rabo, unas ubres, etc..). Pues como se aprecia en ambos aprendizajes, los datos (etiquetados o no) son claves en el enseñar correctamente a un sistema de IA.

El renacimiento de la IA de los últimos años (el concepto de IA se acuño en 1956) se debe a dos motivos principalmente: (1) las mejoras tecnológicas de los ordenadores para realizar cálculos en poco tiempo y (2) la gran disponibilidad de datos derivados de la era digital en la que vivimos. Además, el uso extensivo actual de técnicas de Aprendizaje Profundo (Deep Learning), dónde la máquina decide los parámetros más relevantes de los datos para realizar una tarea, han puesto a los datos en el punto de mira de los desarrolladores y sobre todo las grandes compañías, llegando a ser muy cotizados, igual o más incluso que el petróleo.

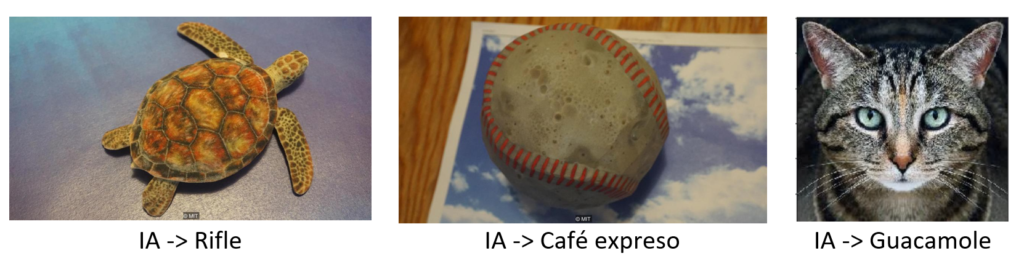

¿Calidad o cantidad? Para enseñar correctamente una tarea los datos son fundamentales. Ya en su momento vimos que una IA incorrectamente entrenada puede dar lugar a errores incompresibles por un ser humano: confundir una tortuga con un rifle, una pelota de béisbol con un café expreso o incluso un gato por guacamole.

La cantidad de datos es importante a la hora de entrenar una IA. Mientras más casos mejor. Sin embargo, su calidad es muy importante. Datos etiquetados incorrectamente pueden confundir a la IA. De ahí que se diga que, si entrenamos con “basura”, obtendremos “basura”. Esto es conocido como GIGO, del inglés “Garbage In, Garbage Out”. Así que la calidad prima sobre la calidad. En caso de falta de datos, existen técnicas para generar datos sintéticos, como vimos hace unas semanas con las redes GAN (https://cienciacarbonica.es/real-o-falso/).

Quizás por ese motivo, vemos noticias casi cada día de que los gigantes tecnológicos (Google, Facebook, etc.) se apoderan de nuestros datos para, entre otras cosas, entrar modelos de IA. Hace unos días, Amazon reconoció que guarda de por vida todas las conversaciones de los usuarios con Alexa, su asistente virtual. Si es que toda esa información debe valer más que el petróleo.

A modo de curiosidad, recientemente Google desarrolló un sistema basado en IA para, a través de nuestra cámara del móvil, generar imágenes de profundidad. Ésta es una tarea difícil si no se dispone de dos cámaras perfectamente calibradas. Así que … ¿cómo lo hizo Google? Pues entrenó su IA con datos recopilados de los vídeos del Mannequin Challenge, que fue muy popular hace unos años. En dichos vídeos, una cámara se mueve mientras las personas y objetos se mantienen inmóviles, entorno perfecto para la tarea que realiza esta tarea. Quien sabe, ¿habrá oscuros intereses detrás de los challenges para obtener datos de entrenamiento para las IA? Ahí lo dejo para que lo meditéis mientras disfrutáis del veranito.

3 comentarios